Três empresas líderes em inteligência artificial registaram uma diminuição notável dos retornos resultantes dos seus dispendiosos esforços para desenvolver novos sistemas de IA. O novo modelo da OpenAI, conhecido como Orion, não alcançou o desempenho desejado pela empresa, a próxima iteração Gemini do Google não está atendendo às expectativas e a Anthropic está enfrentando um atraso no cronograma de seu modelo Claude, chamado 3.5 Opus.

Fonte da imagem: unsplash.com

Depois de anos lançando produtos de IA cada vez mais complexos, as três principais empresas do setor estão vendo retornos decrescentes nos dispendiosos esforços para criar novos modelos. Está a tornar-se cada vez mais difícil encontrar fontes novas e inexploradas de dados de alta qualidade para treinar sistemas de IA mais avançados. E as actuais melhorias muito modestas não são suficientes para recuperar os enormes custos associados à criação e operação de novos modelos, bem como para satisfazer as expectativas do lançamento de novos produtos.

Assim, a OpenAI afirmou que estava à beira de um marco importante. Em setembro, foi concluída a rodada inicial de treinamento para um novo modelo em grande escala do Orion, que estaria mais perto de criar uma IA poderosa que poderia superar os humanos. Mas as expectativas da empresa, segundo fontes bem informadas, não foram atendidas. Orion não conseguiu demonstrar o avanço que o modelo GPT-4 havia mostrado anteriormente em comparação com o GPT-3.5.

Fonte da imagem: Pixabay

A Antrópica, assim como seus concorrentes, enfrentou desafios durante o desenvolvimento e treinamento do 3.5 Opus. Segundo especialistas, o modelo 3.5 Opus teve um desempenho melhor que a versão antiga, mas não tão significativo quanto o esperado, dados o tamanho do modelo e os custos de sua criação e lançamento.

Estas questões desafiam a sabedoria prevalecente em Silicon Valley sobre a escalabilidade da IA. Os defensores globais da IA devem reconhecer que mais poder computacional, mais dados e modelos maiores ainda não abrem caminho para avanços tecnológicos na IA.

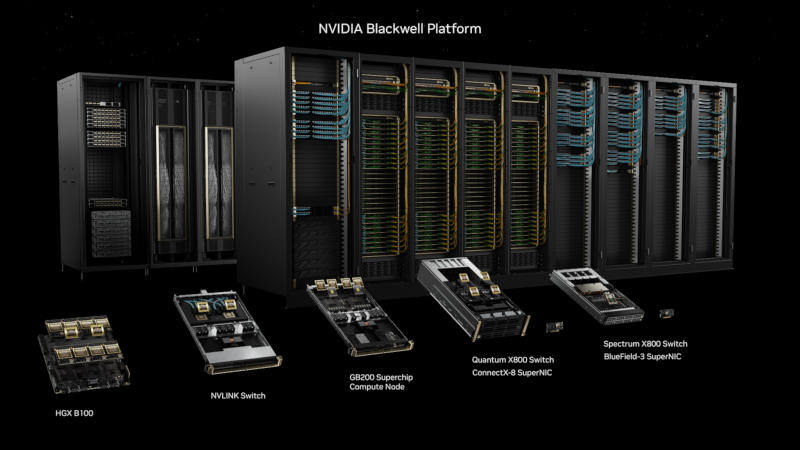

Fonte da imagem: NVIDIA

Os especialistas têm dúvidas razoáveis sobre o retorno do investimento em IA e o objetivo abrangente que os desenvolvedores de modelos de IA buscam: inteligência artificial geral (AGI). O termo é geralmente aplicado a sistemas hipotéticos de IA que podem igualar ou superar os humanos na maioria das tarefas inteligentes. Executivos da OpenAI e da Anthropic disseram anteriormente que a AGI pode demorar alguns anos.

A tecnologia por trás do ChatGPT e dos chatbots de IA concorrentes foi criada usando dados de mídias sociais, comentários online, livros e outras fontes da Internet. Estes dados têm sido suficientes para criar produtos que geram ensaios e poemas substitutos, mas o desenvolvimento de sistemas de IA que ultrapassem a inteligência dos vencedores do Prémio Nobel – como algumas empresas esperam – pode exigir outras fontes de dados para além das publicações na Wikipédia e das legendas no YouTube.

Fonte da imagem: unsplash.com

A OpenAI foi forçada a chegar a acordos com editores para satisfazer pelo menos parte da procura de dados de alta qualidade, ao mesmo tempo que se adaptava à crescente pressão legal dos detentores de direitos de autor de conteúdos utilizados para treinar IA. Há uma grande demanda no mercado de trabalho por especialistas com formação superior que possam rotular dados relacionados à sua área de competência. Isso ajuda a tornar os sistemas de IA treinados mais eficientes no atendimento de dúvidas.

Esses esforços são mais caros e exigem muito mais tempo do que simplesmente indexar a Internet. Assim, as empresas tecnológicas estão a recorrer a dados sintéticos, como imagens ou textos gerados por computador que imitam conteúdos gerados por seres humanos. No entanto, esta abordagem tem as suas limitações, uma vez que é difícil obter melhorias qualitativas quando se utilizam tais dados para treino de IA.

No entanto, as empresas de IA continuam a seguir o princípio de “mais é melhor”. Num esforço para criar produtos que se aproximem da inteligência humana, as empresas tecnológicas estão a aumentar a quantidade de poder computacional, de dados e de tempo gasto na formação de novos modelos, aumentando os custos. O CEO da Anthropic, Dario Amodei, disse que as empresas gastarão US$ 100 milhões este ano para treinar os modelos mais recentes, um número que pode chegar a US$ 100 bilhões nos próximos anos.

Fonte da imagem: unsplash.com

Certamente há potencial para melhorar os modelos de IA além da escalabilidade. Por exemplo, para seu novo modelo Orion, a OpenAI usa um processo pós-treinamento que dura meses. Este procedimento envolve usar o feedback das pessoas para melhorar as respostas e refinar o “tom emocional” das interações com os usuários.

Os desenvolvedores de modelos de IA enfrentam uma escolha: oferecer modelos antigos com melhorias adicionais ou lançar novas versões extremamente caras que podem não ter um desempenho muito melhor. À medida que os custos aumentam, também aumentam as expectativas – os rápidos avanços da IA na sua infância criaram grandes expectativas tanto entre profissionais como entre investidores.