A AMD e a NVIDIA revelaram hoje novas soluções gráficas para computação de alto desempenho com base no trabalho de algoritmos de inteligência artificial. E se no caso da NVIDIA estamos falando em atualizar o acelerador A100 já existente, o que aumentou a quantidade de memória e sua largura de banda, a AMD apresentou uma solução completamente nova na forma do acelerador Instinct MI100 baseado na nova arquitetura CDNA.

Fonte da imagem: NVIDIA

A nova versão do acelerador gráfico NVIDIA A100, assim como o original, é baseada na arquitetura Ampere. A novidade se diferencia da versão anterior pelo aumento de 40 para 80 GB na quantidade de memória HBM2e, bem como pelo aumento da largura de banda de 1.555 para 2 TB / s. Outras características de ambas as versões do acelerador são as mesmas.

Fonte da imagem: NVIDIA

Fonte da imagem: NVIDIA

No momento, a nova versão do A100 é apresentada apenas no formato SXM3, portanto, deve ser usada como parte da plataforma de computação DGX da própria NVIDIA, bem como como parte de plataformas HGX de parceiros. Este último apresentará kits especiais no início do próximo ano para integrar a nova versão do A100 em suas soluções existentes, incluindo opções que suportam a instalação de 4 e 8 aceleradores.

Fonte da imagem: AMD

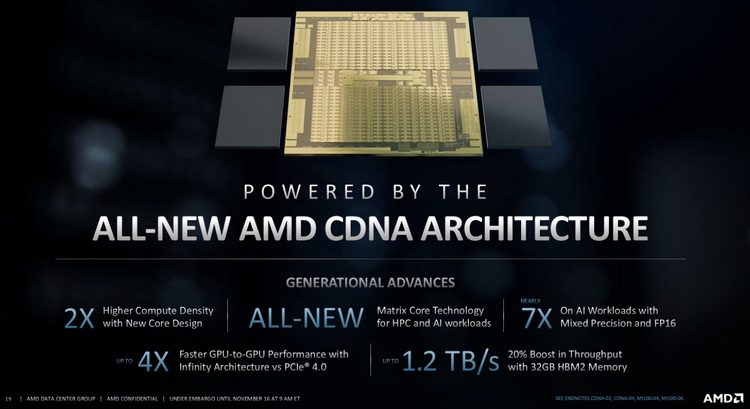

A novidade do NVIDA terá que competir com uma solução completamente nova da AMD – o acelerador gráfico computacional Instinct MI100, construído com base na arquitetura CDNA de 7 nm. Ao contrário da arquitetura RDNA, que é usada em soluções de jogos e renderização profissional, o perfil principal do CDNA é a computação de alto desempenho e o trabalho com algoritmos de inteligência artificial.

Fonte da imagem: AMD

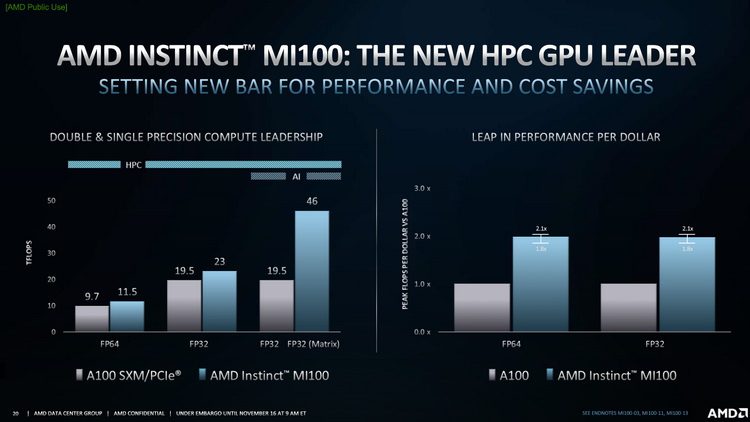

AMD Instinct MI100 foi projetado para funcionar com a interface PCIe 4.0 x16 (64 GB / s). O GPU Instinct MI100 usa 120 unidades de computação, que contêm novos blocos para operações de matriz que são usadas em tarefas de aceleração de computação relacionadas a algoritmos de IA. De acordo com a AMD, os novos blocos não funcionam às custas da computação clássica. Por exemplo, o desempenho máximo em aplicativos FP64 é 11,5 teraflops, e para FP32 é exatamente o dobro – 23 teraflops, que é mais alto do que o desempenho declarado para NVIDIA A100.

Fonte da imagem: AMD

No entanto, nos mesmos cálculos do bfloat16, o Instinct MI100 da AMD perde para seu concorrente – 92,3 teraflops contra 312 teraflops. Para ser justo, deve-se notar que estamos falando de uma comparação com a versão SXM do acelerador NVIDIA A100. A versão PCIe do acelerador da NVIDIA pode ser um pouco mais lenta devido ao menor consumo de energia em tarefas reais. Por sua vez, o Instinct MI100 é apresentado atualmente apenas no fator de forma de uma placa PCIe de tamanho normal com um nível de consumo de 300 watts.

O AMD Instinct MI100 está equipado com 32 GB de memória HBM2 com largura de banda de 1,23 TB / s. Em comparação, o NVIDIA A100 original tem 40 GB de memória HBM2e com largura de banda de 1.555 TB / s. Com três interfaces Infinity Fabric (IF) de 92 GB / s (276 GB / s no total), até quatro aceleradores Instinct MI100 podem ser encadeados um-para-um. Ao mesmo tempo, o nível de largura de banda não depende de quais interfaces (PCIe 3.0 ou 4.0) o conjunto de Instinct MI100 está conectado. A mesma versão PCIe do NVIDIA A100 possui apenas uma interface NVLink, permitindo que apenas duas placas sejam combinadas. No entanto, a largura de banda é maior e atinge 600 GB / s.

De acordo com a AMD, sua nova solução é 1,8-2,1 vezes mais atraente em termos de desempenho por dólar do que a NVIDIA com seu A100.

Fonte da imagem: AMD

Dell PowerEdge R7525, Gigabyte G482-Z54, HPE Apollo 6500 Gen10 Plus e Supermicro AS-4124GS-TNR serão os primeiros sistemas a receber os novos aceleradores gráficos de computação AMD Instinct MI100. Nota-se que alguns dos parceiros da empresa já receberam novos aceleradores, bem como sistemas baseados neles para avaliação de desempenho e adaptação de software.

Mais detalhes sobre os anúncios dos aceleradores gráficos computacionais NVIDIA A100 e MD Instinct MI100 podem ser encontrados no recurso especializado servernews.ru.