As tecnologias NVIDIA NVLink e NVLink Fusion levarão o desempenho de inferência de IA a um novo nível com maior escalabilidade, flexibilidade e recursos de integração de terceiros que, juntos, abordam o rápido crescimento na complexidade do modelo de IA, disse a NVIDIA em uma postagem de blog.

À medida que os modelos de IA se tornaram cada vez mais complexos, seu número de parâmetros cresceu de milhões para trilhões, exigindo recursos computacionais significativos na forma de clusters de aceleradores para dar suporte à sua operação. A introdução de arquiteturas de computação de modo misto (MoE) e algoritmos de raciocínio de IA com escalonamento em tempo de teste (TTS) também contribui para a crescente demanda por recursos computacionais.

A NVIDIA introduziu a interconexão NVLink em 2016. A quinta geração do NVLink, lançada em 2024, permite que 72 aceleradores sejam conectados em um único rack com canais de 1800 GB/s (900 GB/s em cada direção), fornecendo uma taxa de transferência total de 130 TB/s – 800 vezes mais do que a primeira geração.

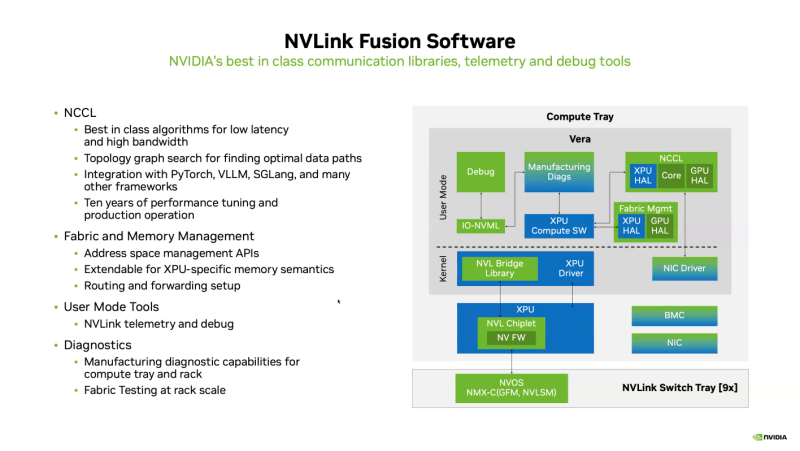

O desempenho do NVLink depende de hardware e bibliotecas de comunicação, especialmente a NVIDIA Collective Communication Library (NCCL), para acelerar a comunicação entre aceleradores em topologias de nó único e múltiplo. A NCCL suporta escalonamento vertical e horizontal e inclui detecção automática de topologia e otimização da transferência de dados.

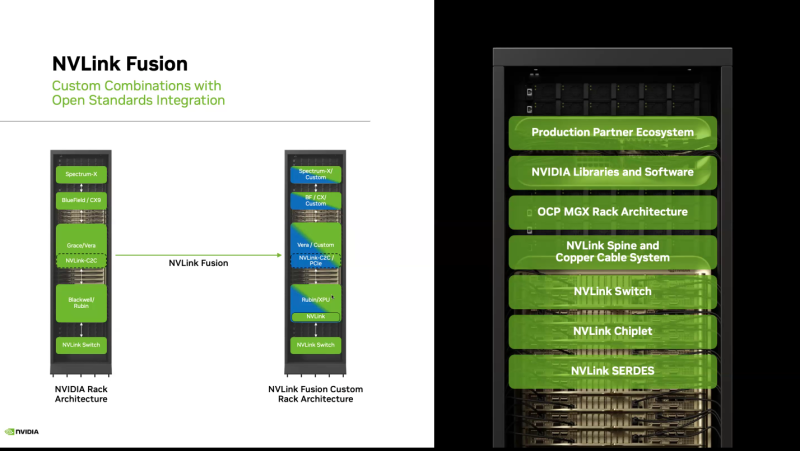

A tecnologia NVLink Fusion foi projetada para fornecer aos hiperescaladores acesso a todas as tecnologias de escalonamento comprovadas em produção da NVLink. Ela permite a integração de silício personalizado (CPUs e XPUs) com a tecnologia de escalonamento vertical e horizontal NVIDIA NVLink e arquitetura de montagem em rack para implantar infraestruturas de IA personalizadas.

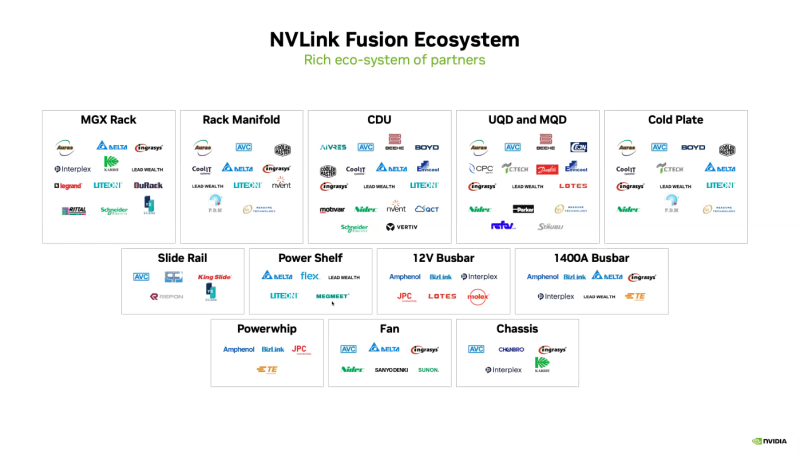

A tecnologia abrange NVLink SerDes, chiplets, switches e arquitetura de rack, oferecendo soluções versáteis para CPUs personalizadas, XPUs personalizadas ou configurações de plataforma combinadas. A solução de rack modular OCP MGX, que permite a integração do NVLink Fusion com qualquer adaptador de rede, DPU ou switch, oferece aos clientes a flexibilidade de criar as soluções de que precisam, afirmou a NVIDIA.

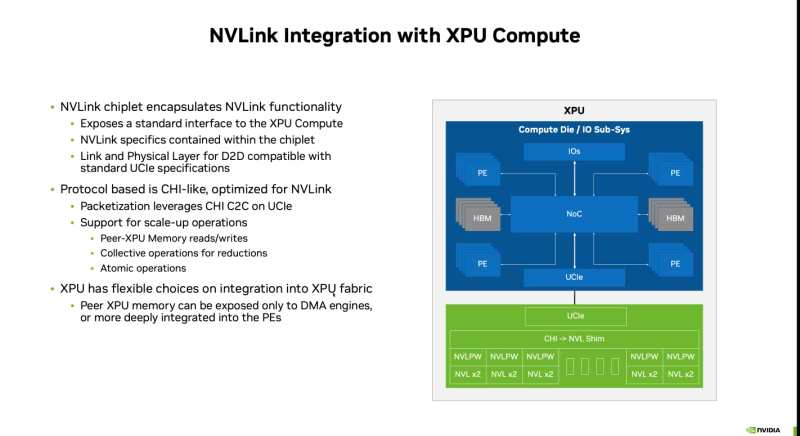

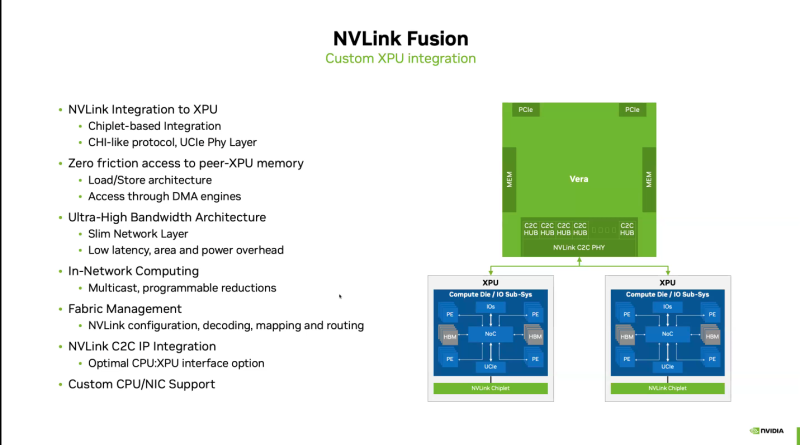

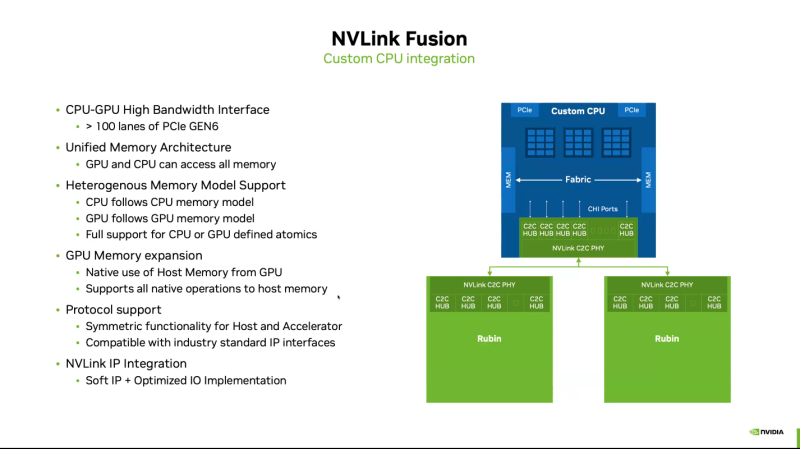

O NVLink Fusion suporta configurações personalizadas de CPU e XPU usando IP e a interface UCIe, oferecendo aos clientes a flexibilidade de implementar a integração de XPU em todas as plataformas. Para configurações personalizadas de CPU, a integração com o NVLink-C2C IP é recomendada para otimizar a conectividade e o desempenho da GPU, além de oferecer uma variedade de modelos de acesso à memória e DMA.

O NVLink Fusion utiliza um amplo ecossistema de silício, incluindo silício personalizado, CPU e parceiros de propriedade intelectual, para fornecer amplo suporte e desenvolvimento rápido de novas soluções. Com base em décadas de tecnologia NVLink e nos padrões abertos da arquitetura OCP MGX, a plataforma NVLink Fusion oferece aos hiperescaladores desempenho e flexibilidade excepcionais para construir infraestruturas de IA, afirmou a NVIDIA.

Ao mesmo tempo, a principal aplicação do NVLink Fusion, do ponto de vista da NVIDIA, aparentemente deveria ser a unificação de chips de terceiros com os seus, e não chips “estrangeiros” entre si. Uma alternativa mais aberta ao NVLink deveria ser o UALink, com maior escalabilidade via Ultra Ethernet.