O Google disse que sua nova família de modelos de IA tem uma característica curiosa: a capacidade de “reconhecer” emoções. A família de modelos de IA PaliGemma 2, revelada quinta-feira, pode analisar imagens, permitindo que a IA gere legendas e responda perguntas sobre as pessoas que “vê” nas fotos, disse a empresa.

Fonte da imagem: Google

«PaliGemma 2 gera legendas detalhadas e contextualmente relevantes para imagens, indo além da simples identificação de objetos para descrever ações, emoções e a narrativa geral de uma cena”, escreve o Google em seu blog oficial. Para reconhecer emoções, o PaliGemma 2 deve ser configurado adequadamente. Sem isso não funciona. No entanto, os especialistas com quem os jornalistas do TechCrunch conversaram ficaram alarmados com a perspectiva de um detector de emoções disponível publicamente.

«Isso me preocupa muito. Acho problemático pensar que podemos “ler” as emoções das pessoas. É como pedir conselhos a um Magic 8 Ball sobre grandes questões”, disse Sandra Wachter, professora de ética de dados e IA do Oxford Research Institute, ao TechCrunch Internet.

As empresas de tecnologia de IA vêm tentando há anos criar inteligência artificial que possa detectar aspectos emocionais em tudo, desde treinamento de vendas até tarefas relacionadas à prevenção de acidentes.

O desenvolvimento da maioria dos detectores de emoções baseia-se nos primeiros trabalhos do psicólogo americano Paul Ekman, que propôs que as pessoas têm seis tipos básicos de emoções: raiva, surpresa, nojo, prazer, medo e tristeza. No entanto, pesquisas subsequentes sobre esta questão lançaram dúvidas sobre a hipótese de Ekman e mostraram que existem sérias diferenças na forma como os representantes dos diferentes estratos da sociedade expressam os seus sentimentos.

«Definir as emoções de uma forma geral e universal é impossível porque as pessoas vivenciam as emoções de maneiras complexas. Achamos que olhando para as pessoas podemos determinar como elas se sentem. E esta técnica foi testada por várias pessoas ao longo dos anos, incluindo agências de inteligência e empresas de publicidade. Tenho certeza de que em alguns casos é absolutamente possível encontrar algumas características comuns, mas não é disso que se trata e não é algo para o qual acabará por haver uma resposta universal”, disse Mike, pesquisador de IA da Queen Mary University of London. .Mike Cook em entrevista ao TechCrunch.

Os especialistas acreditam que os sistemas de detecção de emoções geralmente não são confiáveis e são tendenciosos devido às opiniões específicas dos próprios desenvolvedores de tais sistemas. Num estudo do MIT de 2020, os cientistas mostraram que os modelos de análise facial podem formar preferências não intencionais para certas expressões faciais, como o sorriso. Pesquisas mais recentes mostram que os modelos de análise emocional atribuem mais emoções negativas aos rostos das pessoas negras do que aos rostos das pessoas brancas.

O Google afirma que conduziu “testes extensivos” para avaliar o preconceito demográfico no PaliGemma 2 e encontrou “níveis significativamente mais baixos de toxicidade e palavrões” em comparação com os benchmarks da indústria. No entanto, a empresa não forneceu uma lista completa dos benchmarks utilizados nem indicou quais tipos de testes foram realizados.

O único benchmark de que o Google falou é o FairFace, que consiste em um conjunto de dezenas de milhares de retratos de pessoas. A empresa afirma que o PaliGemma 2 teve um bom desempenho na avaliação FairFace. Mas alguns especialistas criticaram o benchmark pelo seu preconceito, observando que o FairFace não representa todos os grupos raciais, mas apenas alguns.

«Interpretar emoções é uma questão bastante subjetiva que vai além do uso de meios visuais e está intimamente relacionada ao contexto pessoal e cultural. Deixando a IA de lado, a pesquisa mostra que não podemos reconhecer emoções apenas pelas características faciais, diz Heidy Khlaaf, cientista-chefe de IA do AI Now Institute, uma organização sem fins lucrativos que estuda as implicações sociais da inteligência artificial.

Na UE, a utilização de sistemas de reconhecimento de emoções levantou sérias questões entre os reguladores. A Lei da IA, a principal peça legislativa da UE sobre IA, proíbe escolas e empregadores de usar detectores de emoções. No entanto, não proíbe a sua utilização pelas autoridades responsáveis pela aplicação da lei.

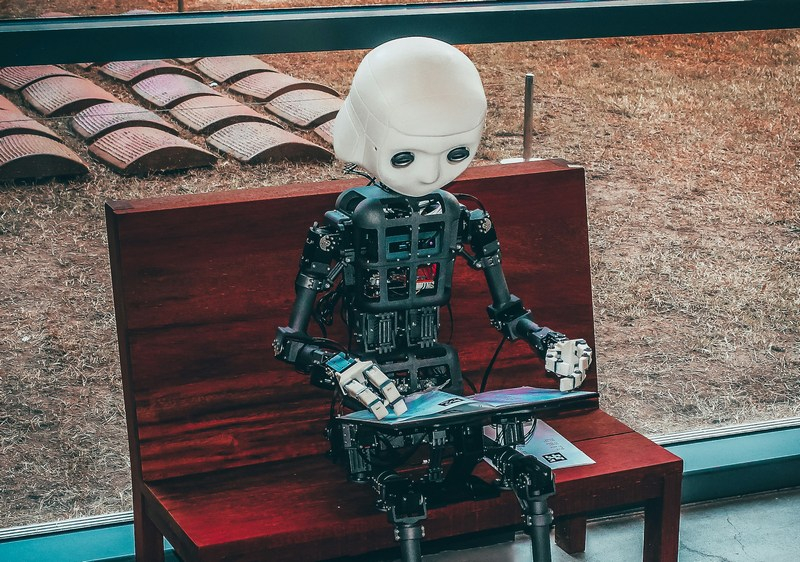

Fonte da imagem: Unsplash

A principal preocupação dos especialistas sobre modelos abertos de IA como o PaliGemma 2, que é distribuído através de várias fontes, incluindo a plataforma de desenvolvimento de IA Hugging Face, é que eles podem ser abusados e mal utilizados, o que pode levar a danos reais.

«Se esta chamada “identificação emocional” se basear em preconceitos e preconceitos pseudocientíficos, então existe um risco significativo de consequências na forma como esta capacidade pode ser usada para subsequentemente e falsamente discriminar vários grupos marginalizados pelas autoridades policiais, empregadores, patrulhas fronteiriças, etc.”, diz Khlaaf.

A Google afirma que a empresa testa os seus modelos de IA para detectar uma predisposição para “danos representacionais” (estereótipos sobre grupos sociais, como raça, etnia, género ou religião, que levam a consequências negativas para esses grupos e os seus representantes). “Avaliamos de forma robusta os modelos PaliGemma 2 de uma perspectiva ética e de segurança, incluindo segurança infantil e segurança de conteúdo”, acrescentou a empresa.

A professora de ética de dados e IA do Oxford Internet Institute, Sandra Wachter, não se convenceu com a resposta da empresa: “Inovação responsável é quando você pensa nas consequências de desenvolvê-la desde o primeiro dia em que trabalha nela, toda vez que você entra em ação. seu laboratório e depois continuar a fazê-lo.” isso ocorre durante todo o ciclo de vida do produto. Posso imaginar muitos problemas potenciais que tais modelos poderiam criar e, em última análise, levar a um futuro distópico em que suas emoções determinarão se você conseguirá um emprego, conseguirá um empréstimo e irá para a faculdade.”