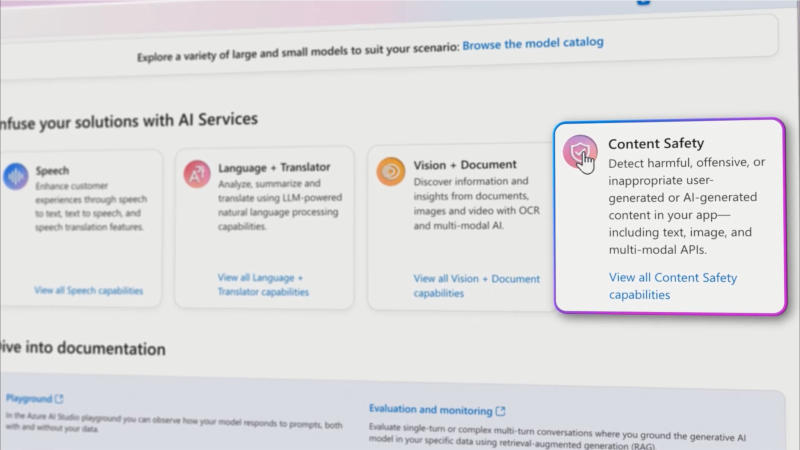

A Microsoft introduziu um novo recurso de Segurança de Conteúdo na infraestrutura de nuvem Azure – ele visa combater falhas na operação de inteligência artificial generativa. O recurso detecta e até corrige automaticamente erros nas respostas dos modelos de IA.

Fonte da imagem: youtube.com/@MicrosoftAzure

A Segurança de Conteúdo está disponível em versão prévia no Azure AI Studio, um conjunto de ferramentas de segurança projetadas para detectar vulnerabilidades, detectar alucinações em sistemas de IA e bloquear solicitações inadequadas de usuários. O Content Safety verifica as respostas da IA e identifica imprecisões nelas, comparando a saída com a entrada do cliente.

Quando um erro é detectado, o sistema o destaca, fornece informações sobre por que as informações fornecidas estão incorretas e reescreve o conteúdo problemático – tudo antes que o usuário possa ver a imprecisão. No entanto, esta função não oferece garantia de confiabilidade. A plataforma empresarial Google Vertex AI também tem uma função para “fundamentar” modelos de IA, verificando as respostas no mecanismo de busca do Google, nos dados da própria empresa e, no futuro, em conjuntos de dados de terceiros.