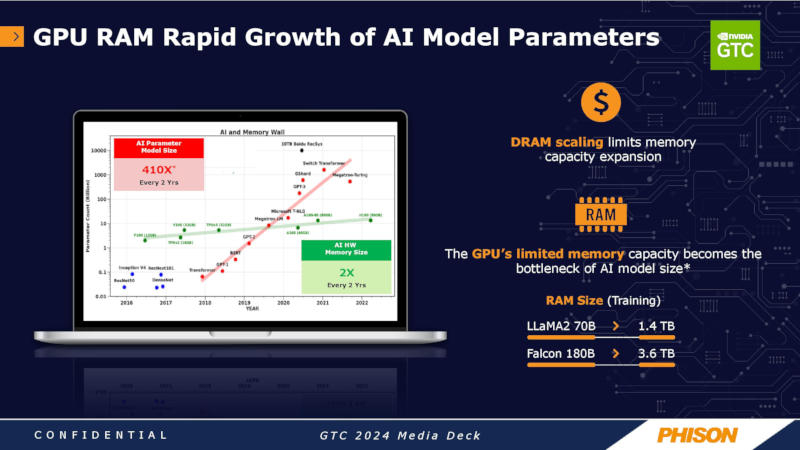

Phison demonstrou no evento Nvidia GTC 2024 uma estação de trabalho com quatro processadores gráficos, que era poderosa o suficiente para treinar um modelo de inteligência artificial com 70 bilhões de parâmetros. Isso foi possível usando os recursos de SSD e DRAM do sistema, relata Tom’s Hardware. Em condições normais, esta tarefa requer seis servidores com 24 aceleradores Nvidia H100 e 1,4 TB de memória de vídeo.

Fonte da imagem: phison.com

A plataforma Phison aiDaptiv+ ajuda a reduzir as barreiras ao treinamento de grandes modelos de linguagem de IA, aproveitando a memória do sistema e SSDs para aumentar a quantidade de memória disponível para GPUs. Esta solução permitirá às empresas reduzir os custos de formação em IA e evitar a escassez de GPU que ameaça a indústria. O desempenho de tal sistema, é claro, é inferior ao de soluções de servidor caras, mas abre a oportunidade para pequenas e médias empresas executarem modelos avançados localmente, garantindo a confidencialidade dos dados se o tempo gasto em treinamento não for crítico.

Fonte da imagem: phison.com

A demonstração usou uma estação de trabalho Maingear Pro AI com processador Intel Xeon W7-3445X, 512 GB de memória DDR5-5600 e dois SSDs Phison aiDaptiveCache ai100E 2 TB M.2 especializados projetados especificamente para armazenar cargas de trabalho em cache. Essas unidades baseadas em chip SLC foram projetadas para suportar 100 ciclos de gravação por dia durante cinco anos. A solução de software aiDaptiv+ da Phison remove camadas do modelo de IA da memória de vídeo que não estão sendo processadas ativamente e as envia para a memória do sistema da máquina; se forem informações necessárias, elas permanecem aqui e os dados de baixa prioridade são descarregados nos SSDs. Eles são movidos para a memória de vídeo da GPU para processamento adicional conforme necessário, e os dados processados são enviados para DRAM e SSD.

Fonte da imagem: tomshardware.com

A estação de trabalho Maingear Pro AI está disponível em diversas versões, de US$ 28 mil para uma versão com um acelerador gráfico Nvidia RTX 6000 Ada A100 a US$ 60 mil para uma configuração com quatro GPUs. O principal parceiro da Phison no fornecimento de equipamentos para a nova plataforma é a Maingear, mas a desenvolvedora também coopera com MSI, Gigabyte, ASUS e Deep Mentor, que estão prontos para oferecer suas soluções.

A biblioteca de middleware aiDaptiv+ da Phison funciona com Pytorch/Tensor Flow e não requer modificação em aplicativos de IA. O custo de treinar um modelo nessa configuração é seis vezes menor do que executá-lo em oito clusters com 30 aceleradores de IA, mas o procedimento leva cerca de quatro vezes mais tempo. Há também a opção de escalonamento horizontal com lançamento de quatro estações de trabalho por pouco mais da metade do custo – neste caso, treinar um modelo com 70 bilhões de parâmetros levará cerca de 1,2 hora, enquanto um sistema com 30 aceleradores de IA fará isso. em 0,8 horas.