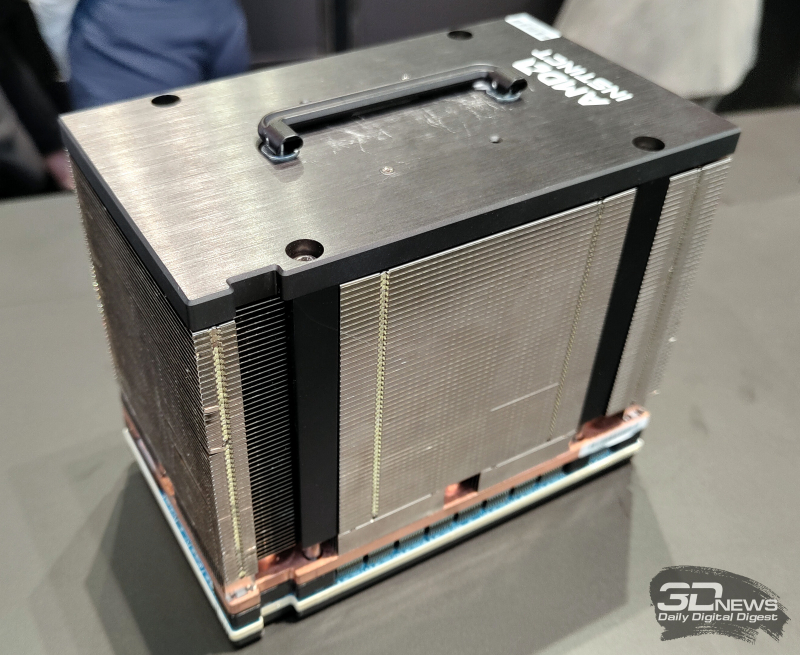

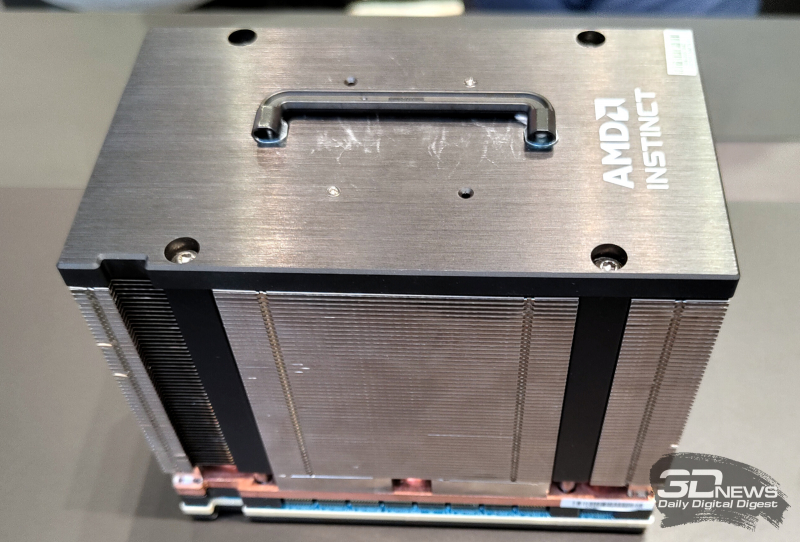

A AMD está preparando novas modificações na família de aceleradores Instinct MI300, que visam processar aplicativos de IA com uso intensivo de recursos. Os produtos serão equipados com memória HBM3E de alto desempenho. O trabalho neles foi confirmado pelo diretor técnico da AMD, Mark Papermaster, e já esta semana uma amostra do acelerador atualizado foi vista no estande da empresa no MWC 2024.

Hoje, a família Instinct MI300 inclui as modificações MI300A e MI300X. O primeiro possui 228 unidades computacionais CDNA3 e 24 núcleos Zen4 na arquitetura x86. O equipamento inclui 128 GB de memória HBM3. O acelerador MI300X, equipado com 304 blocos CDNA3 e 192 GB HBM3, é voltado para cálculos mais intensivos. Mas esta solução não possui núcleos Zen4.

A Micron anunciou recentemente o início da produção em massa de memória HBM3E de 8 camadas com capacidade de 24 GB e largura de banda superior a 1200 GB/s. Esses chips serão usados nos aceleradores NVIDIA H200 AI, que chegarão ao mercado comercial no segundo trimestre deste ano. E a Samsung está se preparando para fornecer chips HBM3E de 36 GB de 12 camadas com velocidades de transferência de dados de até 1280 GB/s.

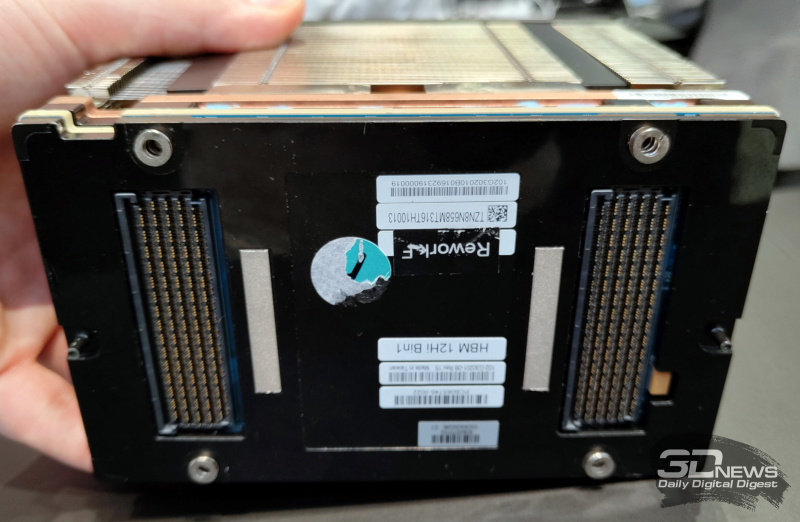

A AMD confirmou sua intenção de usar memória HBM3E nos aceleradores Instinct MI300 atualizados, mas não entrou em detalhes. Ao usar chips HBM3E de 12 camadas com capacidade de 36 GB, um conjunto de oito módulos fornecerá até 288 GB de memória de alta largura de banda. O adesivo na amostra de demonstração indica claramente o uso de memória de 12 camadas. Porém, isso pode realmente ser apenas um adesivo, já que o representante da AMD evitou responder diretamente à pergunta sobre as especificações do produto apresentado.

A AMD também deverá lançar aceleradores de IA de próxima geração, a série Instinct MI400, em 2025. Enquanto isso, a NVIDIA está preparando aceleradores da família Blackwell para tarefas de IA: esses produtos, segundo a própria empresa, estarão em falta imediatamente após entrarem no mercado.