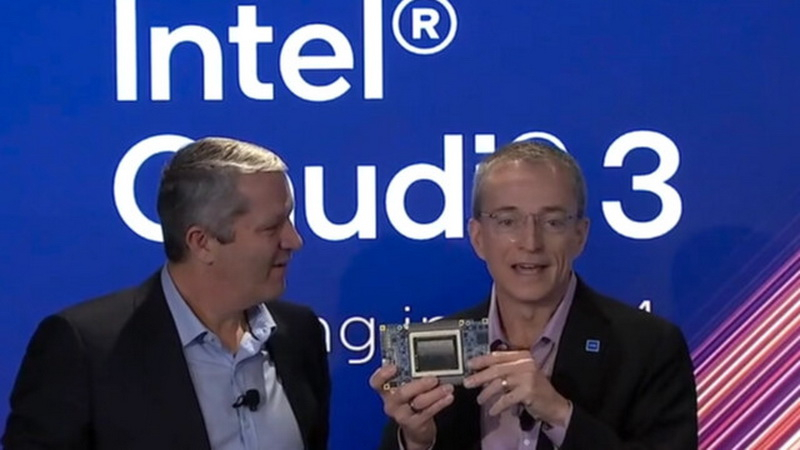

Como parte do evento AI Everywhere, que apresentou seus processadores móveis de consumo Core Ultra e chips de servidor escaláveis Xeon de 5ª geração, o CEO da Intel, Pat Gelsinger, também deu uma prévia do Gaudi3, um acelerador de computação de IA dedicado com lançamento previsto para 2024. . Tornar-se-á uma alternativa mais acessível às soluções da NVIDIA e AMD.

Fonte da imagem: Intel

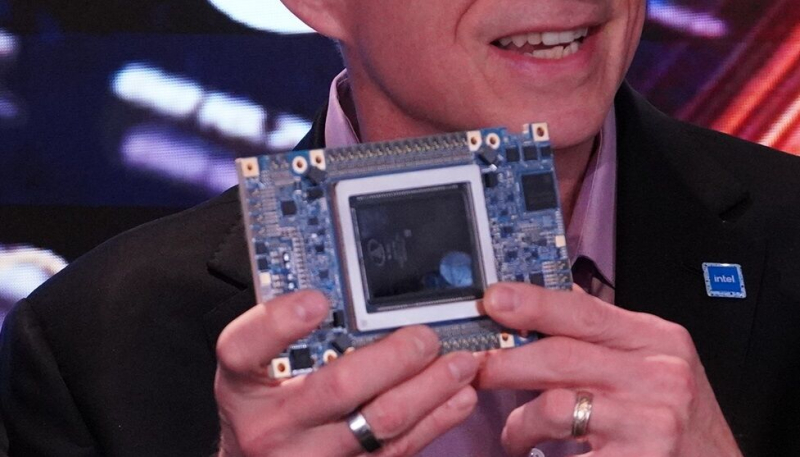

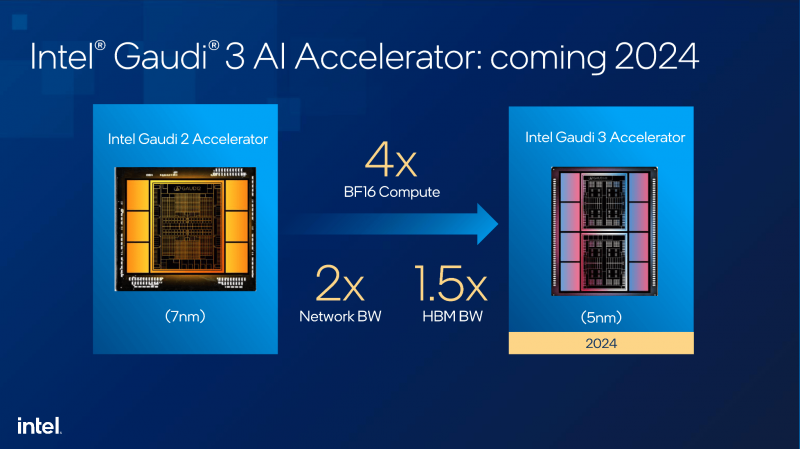

Segundo Gelsinger, Gaudi3 está sendo testado nos laboratórios da empresa. O chefe da Intel mostrou um novo produto composto por uma placa de circuito impresso e um enorme processador gráfico, rodeado por oito módulos de memória HBM3 de alta velocidade (Gaudi2 está equipado com seis chips de memória HBM3). Segundo Gelsinger, Gaudi3 será significativamente mais produtivo que seu antecessor. O consumo de energia de Gaudi2 é de cerca de 600 W, e você pode esperar o mesmo consumo de energia ou um pouco maior de Gaudi3.

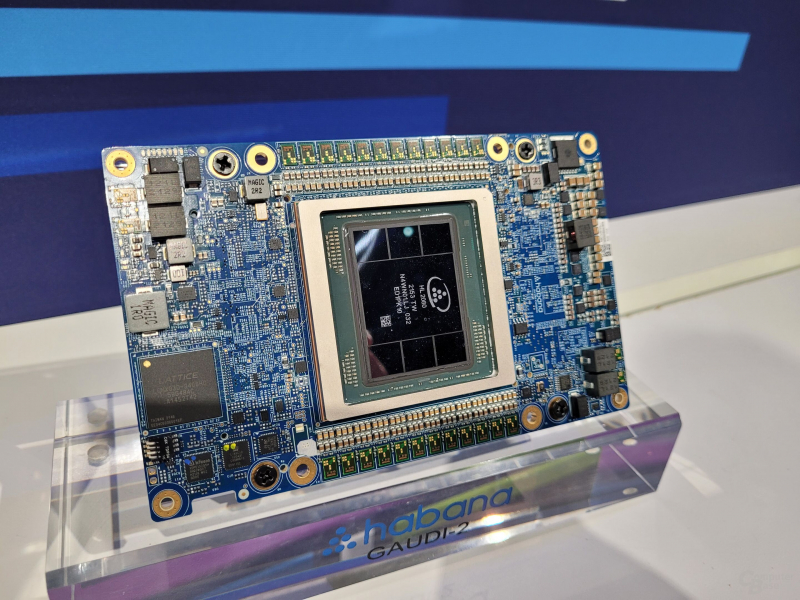

Intel Gaudí2

A Intel admite que Gaudi3 em termos de desempenho puro não será capaz de se igualar aos mesmos aceleradores NVIDIA H100, aos próximos aceleradores H200 no segundo semestre de 2024 e ao subsequente Blackwell B100. No entanto, o segmento de computação de IA está em constante crescimento, por isso a Intel acredita que nem todos os casos exigem soluções tão grandes e que consomem muita energia como as oferecidas pelos concorrentes.

A empresa está confiante de que conseguirá competir no mercado de aceleradores de IA, oferecendo uma alternativa interessante com uma relação preço-desempenho atrativa. O mesmo Gaudi2 já ocupou seu nicho no segmento, já que as soluções NVIDIA se esgotam com muitos meses de antecedência e os aceleradores da série AMD MI200 são produzidos em quantidades muito pequenas. Graças a isso, as vendas dos aceleradores Gaudi estão crescendo rapidamente.

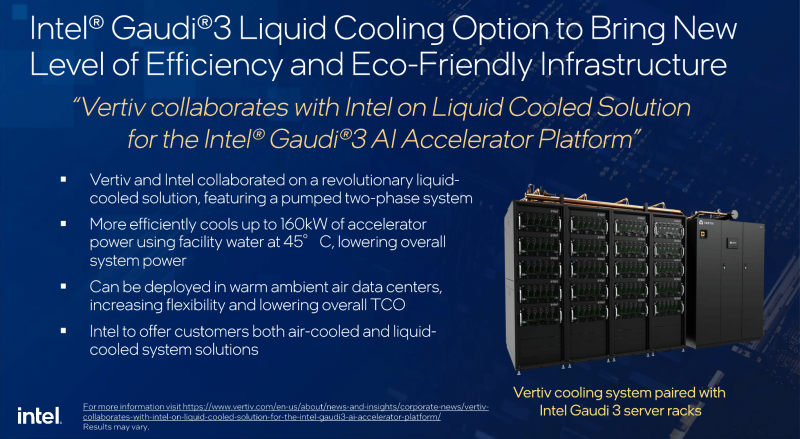

Os aceleradores Gaudi3 serão oferecidos não apenas como módulos separados, mas também como parte de instâncias pré-fabricadas com refrigeração líquida. Para conseguir isso, a Intel fez parceria com a Vertiv, empresa que fornece soluções críticas para infraestrutura digital. A propósito, a NVIDIA também colabora com isso há muito tempo.