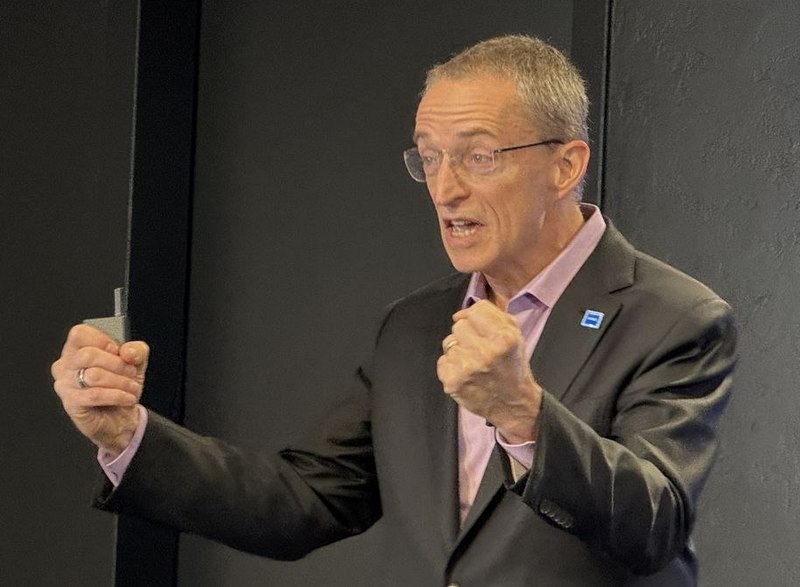

O CEO da Intel, Pat Gelsinger, criticou a tecnologia CUDA da NVIDAI durante a apresentação dos chips Intel Core Ultra e Xeon Scalable de 5ª geração. Ele observou que “toda a indústria está motivada para eliminar o CUDA” porque a solução da NVIDIA é fechada, enquanto os desenvolvedores de IA precisam de tecnologias abertas.

Lembramos que CUDA (Compute Unified Device Architecture) é uma arquitetura de hardware e software para computação paralela, patenteada pela NVIDIA e funcionando exclusivamente com seus processadores gráficos e aceleradores computacionais. Devido à natureza fechada da plataforma, os desenvolvedores ficam vinculados às soluções NVIDIA ou são forçados a retrabalhar seus projetos para outro hardware se quiserem mudar para ele.

Respondendo a perguntas de representantes da NASDAQ, Gelsinger sugeriu que o domínio da NVIDIA no campo de treinamento de redes neurais baseadas em tecnologias CUDA não durará para sempre. “Sabe, toda a indústria está motivada para eliminar o mercado CUDA”, lamenta Gelsinger. Ele citou desenvolvedores como MLIR, Google e OpenAI como exemplos, sugerindo que eles estão migrando para a “programação de estilo Python” (sem regras) para tornar o aprendizado de IA mais aberto. “Acreditamos que o fosso da CUDA é raso e pequeno”, continuou Gelsinger. “Porque a indústria está motivada a adotar um conjunto mais amplo de tecnologias para aprendizagem, inovação, ciência de dados, etc.”

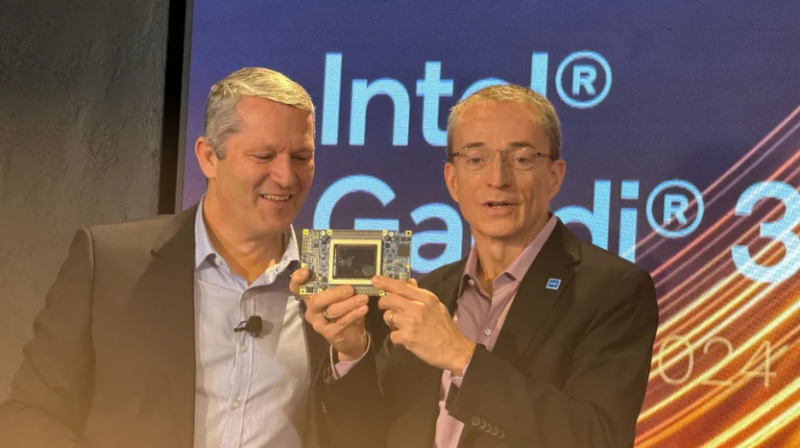

Ao mesmo tempo, a Intel acredita que os desenvolvedores de aceleradores computacionais não devem confiar apenas no treinamento de redes neurais – eles também precisam criar produtos para a operação de redes neurais já treinadas (inferência). “Depois de treinar o modelo, o resultado acontece… Não há dependência do CUDA”, continua Gelsinger. “É tudo uma questão de você conseguir administrar bem este modelo?” O chefe da Intel sugeriu que com o acelerador de computação Gaudi 3 revelado ontem, bem como os chips Xeon e processadores convencionais para computadores de consumo, a Intel dará conta da tarefa de lançar o modelo. Não que a Intel não vá competir no espaço de aprendizagem, mas “essencialmente, o mercado de inferência é onde o jogo estará”, disse Gelsinger.

Ele também aproveitou a oportunidade para elogiar o padrão OpenVINO que a Intel desenvolveu em torno de seus esforços de IA. O chefe da Intel previu que o mundo migrará para a computação mista, quando algumas tarefas serão realizadas na nuvem, enquanto outras serão realizadas no computador pessoal do usuário.

Sandra Rivera, vice-presidente executiva e gerente geral do Data Center e Grupo de IA da Intel, acrescentou que a escala da Intel do data center ao PC poderia torná-la um parceiro preferido dos desenvolvedores de IA porque pode produzir em grandes volumes.

A estratégia escolhida parece bastante ambiciosa e Gelsinger parecia confiante ao apresentá-la hoje. Ele pode realmente vencer a tecnologia CUDA? Só o tempo dirá quando os aplicativos de chips de IA que a Intel revelou hoje se tornarão mais difundidos.