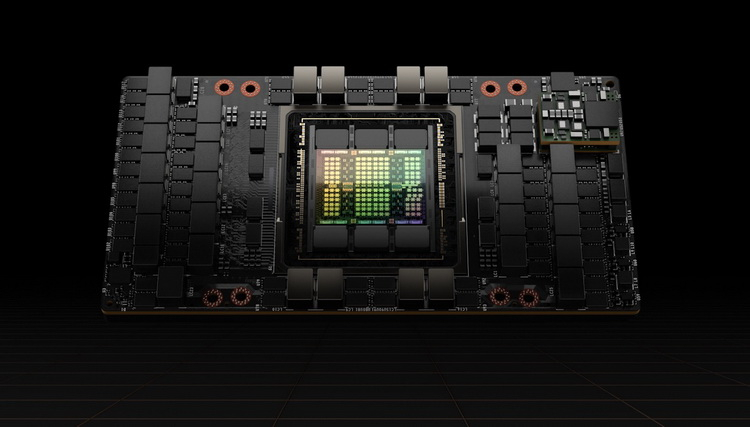

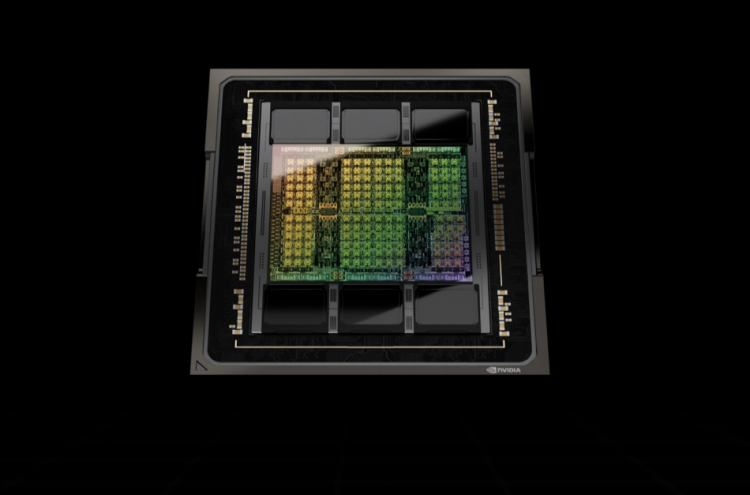

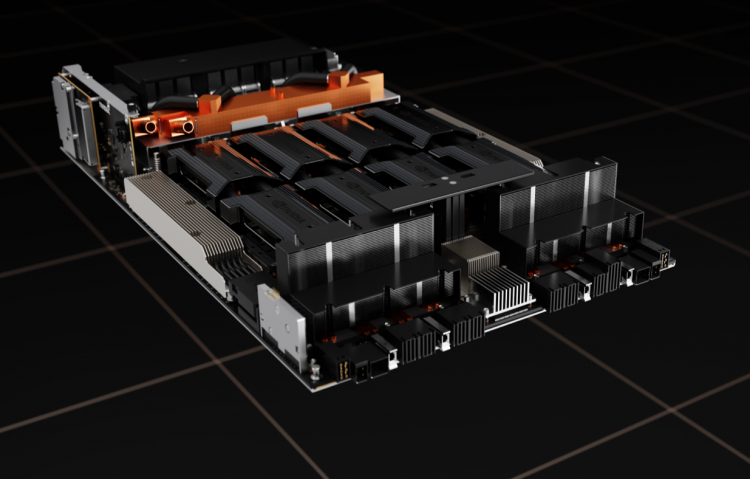

Durante o evento GTC 2022, a NVIDIA anunciou a nova arquitetura gráfica Hopper e os primeiros produtos baseados nela – os aceleradores de computação H100. Seus chips são cerca de 80 bilhões de transistores e são fabricados usando a tecnologia de processo TSMC N4 (5 nm aprimorado).

Fonte da imagem: NVIDIA

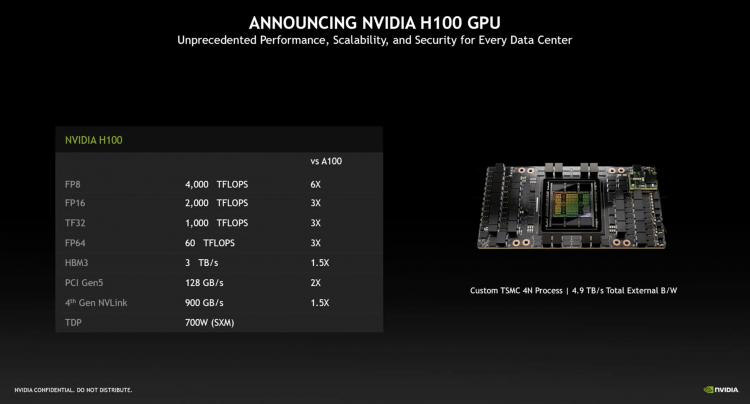

A empresa alega um aumento de três vezes no desempenho em operações FP64, TF32, FP16 e um aumento de seis vezes no desempenho em operações FP8 para o H100 em comparação com o NVIDIA A100.

O H100 também inclui 80 GB de memória HBM3 com largura de banda de 3 TB/s, que é 1,5 vezes mais que o atual acelerador NVIDIA A100 AI.

Os principais recursos dos aceleradores NVIDIA H100 são o novo Transformer Engine, suporte para instruções DPX especiais para programação dinâmica, a segunda geração da tecnologia de virtualização de GPU de múltiplas instâncias, suporte para a 4ª geração do barramento NVLink de 900 GB/s e o novo NVSwitch que permite conectar diretamente até 256 aceleradores. Todas essas inovações podem ser encontradas com mais detalhes no artigo de nossos colegas da ServerNews.

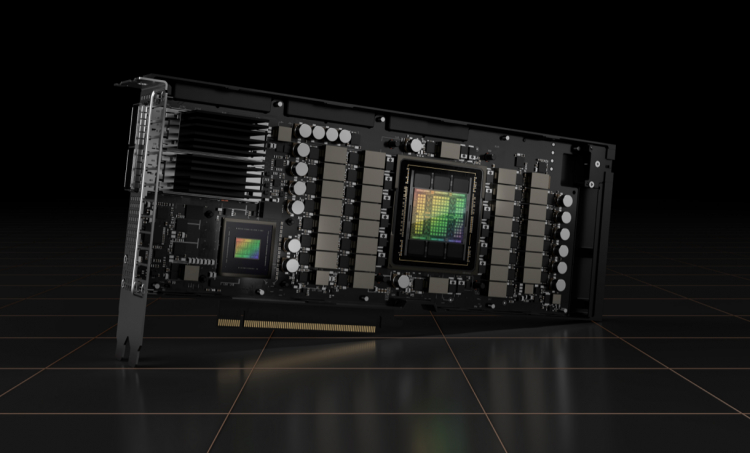

Os aceleradores NVIDIA H100 estarão disponíveis no formato de placa de expansão PCI Express 5.0 com um TDP de 350W e no formato SXM5 com um TDP declarado de 700W, que é 300W a mais que o A100. Ao mesmo tempo, a versão PCIe receberá um chip menos potente com 14.592 núcleos CUDA. O modelo no formato SXM5 será construído em um chip com 16.896 núcleos.

A empresa diz que os primeiros produtos baseados em aceleradores H100 serão a quarta geração de sistemas DGX – DGX H100, que será capaz de fornecer até 32 PFlops de desempenho computacional de IA em operações FP8. Os parceiros oferecerão plataformas HGX para 4 ou 8 aceleradores. A presença da quarta geração do barramento NVLink Switch permitirá a rede de até 32 sistemas DGX H100, formando a próxima geração de supercomputadores NVIDIA DGX SuperPOD em sua base. A própria NVIDIA está atualmente desenvolvendo o supercomputador EOS, que consistirá em 576 sistemas DGX H100 e receberá desempenho FP64 no nível de 275 Pflops e FP16 – 9 Eflops.

Os principais provedores de serviços em nuvem, como Alibaba Cloud, Amazon Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud e Tencent Cloud, já demonstraram interesse na nova arquitetura de Hopper e planejam usar soluções baseadas em acelerador NVIDIA H100 em seus ecossistemas .